I timed my life perfectly. I was born just after the end of the Second World War. I was a teenager before there was AIDS. And now I’m going to die before the end.

Så sa Geoffrey Hinton, en av AI-forskningens pionjärer, när han nyligen lämnade Google för att varna världen om riskerna med artificiell intelligens. Han är inte ensam — även ledarna för de största AI-företagen, som Sam Altman på OpenAI och Dario Amodei på Anthropic, jämför AI:s risker med pandemier och kärnvapenkrig. Även toppolitiker som EU-kommissionens ordförande Ursula von der Leyen verkar dela samma bild.

I förra nyhetsbrevet pratade vi om hur AI-företagen försöker göra sina system säkrare. Men räcker det? Vad mer behöver vi göra?

Idag ska vi dyka in i den stora frågan om AI-styrning (AI governance): Bör vi gasa eller bromsa utvecklingen? På ena sidan står accelerationisterna, eller accels, som vill att regeringar ska hjälpa AI-företagen att utvecklas snabbare, så att demokratiska länder hinner före auktoritära regimer. På andra sidan står de som vill ha en paus innan vi släpper lös krafter vi kanske inte kan kontrollera, som av vissa lite nedsättande kallas decels eller doomers.

Låt oss lyssna på båda sidor.

Decisions made in the next decade are more highly levered to shape the future of humanity than at any point in human history. — Samuel Hammond

Argumenten för acceleration

Accels vill inte bara ha frihet att utveckla AI, utan att staten aktivt ska stötta arbetet. En exempel på deras inflytande är att en amerikansk statlig kommission nyligen föreslog att USA måste göra allt för att hindra Kina från att nå superintelligens först. De vill ha ett nytt Manhattan-projekt för AI, med fullt statligt fokus. Liknande röster finns även i Kina.

Men varför vill de accelerera utvecklingen? Det finns tre huvudargument:

1. Det är vår moraliska plikt. AI kommer att göra världen mycket bättre, så ju snabbare vi når dit desto bättre. Andrew Ng, tidigare chef för Google Brain, uttrycker det så här: “Jag tror att AI kommer att minska den sammanlagda risken för att människan dör ut. Om vi vill att mänskligheten ska överleva och frodas de nästa 1000 åren bör vi skynda på AI-utvecklingen snarare än att bromsa den med betungande regleringar”.

2. Det är oundvikligt. Någon kommer ändå att utveckla superintelligens, så det är meningslöst att försöka bromsa. De som bromsar kommer bara att hamna på efterkälken. Så här tycker roon, som sägs stå Sam Altman nära:

things are accelerating. pretty much nothing needs to change course to achieve agi imo. worrying about timelines is idle anxiety, outside your control. you should be anxious about stupid mortal things instead. do your parents hate you? does your wife love you?

3. Vi måste vinna kapplöpningen. Om auktoritära regimer når superintelligens först blir det en katastrof. Som Sam Altman skriver:

The United States currently has a lead in AI development, but continued leadership is far from guaranteed. Authoritarian governments the world over are willing to spend enormous amounts of money to catch up and ultimately overtake us. Russian dictator Vladimir Putin has darkly warned that the country that wins the AI race will “become the ruler of the world,” and the People’s Republic of China has said that it aims to become the global leader in AI by 2030.

Fördelarna med snabb AI-utveckling är lockande. Dario Amodei på Anthropic menar att vi kan göra hundra års framsteg inom medicin på bara tio år. Tänk att kunna bota cancer, dramatiskt öka livslängden genom att förstå åldrande på molekylnivå, eller hitta botemedel mot schizofreni. AI skulle också kunna hjälpa oss designa bättre solceller, skapa proteiner som bryter ner plastavfall i haven, utveckla klimattåliga grödor och kanske till och med lösa gåtan med fusionskraft.

Många techledare, som Bill Gates och Marc Andreessen, ser AI som vår bästa chans till ett överflödssamhälle. Vissa går ännu längre och menar att det är vår plikt att utveckla AI för att bevara “medvetandets ljus” i universum.

Så hur ska demokratierna vinna kapplöpningen? Amodei föreslår en entente-strategi där demokratiska länder går samman för att säkra viktiga resurser som processorer och datorkraft, och samtidigt blockerar tillgången för motståndare.

Trippelententen var framgångsrik i första världskriget — kan världens demokratier gå samman och vinna kapplöpningen till superintelligens den här gången?

Argument för att stoppa eller pausa AI-utvecklingen

Accels brukar ofta förlöjliga de som vill sakta ner AI-utvecklingen, genom att jämföra dem med grupper som varit skeptiska till tekniska framsteg, som ludditerna eller vaccinmotståndare. Men de som förespråkar en paus i AI-utvecklingen pekar på konkreta risker. Vi diskuterade ju det i detalj i #73: dels det lite läskiga scenariot där AI-verktyg ger terrorister och diktatorer mer makt, dels det mycket läskiga scenariot att mänskligheten släpper lös en intelligens som vi inte kan tygla och som kanske inte gillar konkurrens.

Så vad borde vi göra? En av de mest oroliga rösterna, AI-säkerhetsforskaren Eliezer Yudkowsky, föreslår att vi bör stoppa AI-utveckligen på obestämt tid:

Many researchers steeped in these issues, including myself, expect that the most likely result of building a superhumanly smart AI, under anything remotely like the current circumstances, is that literally everyone on Earth will die. Not as in “maybe possibly some remote chance,” but as in “that is the obvious thing that would happen.” [...]

We are not prepared. We are not on course to be prepared in any reasonable time window. There is no plan. Progress in AI capabilities is running vastly, vastly ahead of progress in AI alignment or even progress in understanding what the hell is going on inside those systems. [...]

Here’s what would actually need to be done: The moratorium on new large training runs needs to be indefinite and worldwide. [...] Shut down all the large GPU clusters. Shut down all the large training runs. Put a ceiling on how much computing power anyone is allowed to use in training an AI system [...] Track all GPUs sold. If intelligence says that a country outside the agreement is building a GPU cluster, be less scared of a shooting conflict between nations than of the moratorium being violated; be willing to destroy a rogue datacenter by airstrike.

Ett mer moderat förslag är att pausa utvecklingen av de mest kraftfulla AI-modellerna i sex månader, för att ge samhället tid att anpassa sig. Detta stöds av Elon Musk, Max Tegmark, Yuval Noah Harari, Steve Wozniak och över 33 000 andra i ett öppet brev.

Should we let machines flood our information channels with propaganda and untruth? Should we automate away all the jobs, including the fulfilling ones? Should we develop nonhuman minds that might eventually outnumber, outsmart, obsolete and replace us? Should we risk loss of control of our civilization? Such decisions must not be delegated to unelected tech leaders. Powerful AI systems should be developed only once we are confident that their effects will be positive and their risks will be manageable. [...] Therefore, we call on all AI labs to immediately pause for at least 6 months the training of AI systems more powerful than GPT4.

Den svenske fysikern Max Tegmark har ett lite annat förslag. Han föreslår att AI-leverantörerna bör ha bevisbördan att visa att deras modeller är säkra, likt läkemedel och kärnkraftverk. För stora språkmodeller tycker han inte att det är bevisat, och därför borde utvecklingen av dem pausas tills det är gjort (vilket sannolikt kräver att man förstår mer om hur de tänker). För mer specifika modeller som löser väldefinierade problem, inom t ex biologi eller självkörande bilar, borde det gå bra att redan nu bygga ett övertygande säkerhetscase som gör att de får säljas. Han är övertygad om att Kina har samma intresse som västvärlden av att undvika osäker superintelligens, och menar att man borde försöka åstadkomma en detente (avspänning) istället mellan supermakterna istället för en entente (allians) mellan bara demokratier.

Så hur ser de som förespråkar en paus på accelerationisternas tre argument? Ungefär så här tror jag:

“First, do no harm”: Visst finns många positiva aspekter med superintelligens, men det mest moraliska och vår första prioritet måste vara att skydda vår nuvarande civilisation.

Det är inte oundvikligt: varför ge upp hoppet om global samordning när vi har lyckats med det för kärnvapen och delvis för CO2-utsläpp? Och kinesiska ledare har ju sagt vid flera tillfällen att de ser vikten av samarbete kring AI-säkerhet.

Att accelerera är farligare, eftersom en entente-strategi kan leda till en kapplöppning om superintelligens där säkerhet nedprioriteras, vilket kan resultera i att det i slutändan inte finns några (mänskliga) vinnare.

Vad vill man pausa? Inte all AI-utveckling, utan specifikt utvecklingen av ständigt kraftfullare processorer, och användandet av dem för att träna större “generella” modeller än dagens ChatGPT. Förespråkarna menar att vi lyckats pausa eller stoppa forskningen också på andra känsliga områden, som mänsklig kloning och eugenik (mänsklig avel), så det borde vara möjligt även med AI.

En kompromiss: ansvarsfull uppskalning

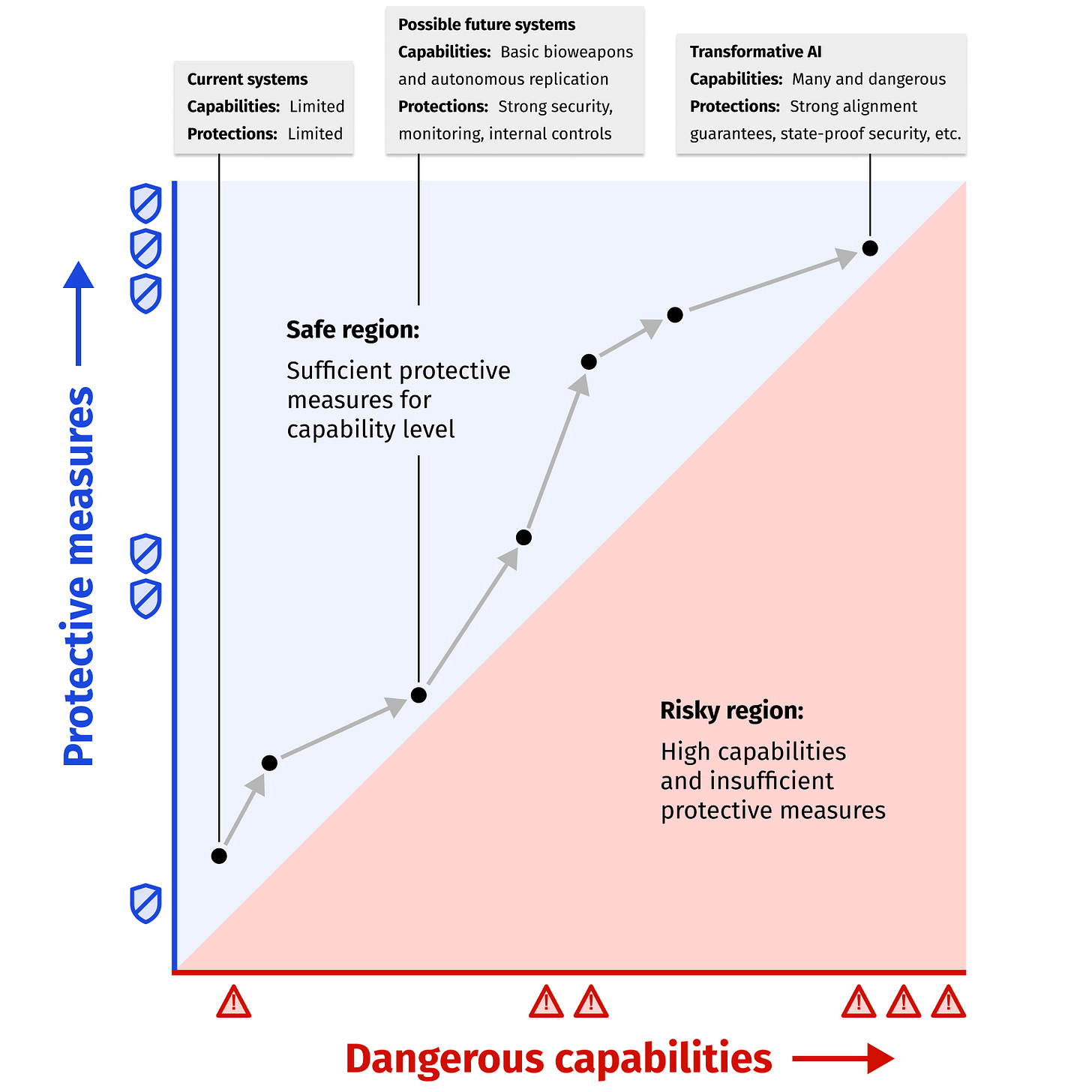

Mellan de som vill gasa och de som vill bromsa finns en pragmatisk mellanväg: låt AI-labben fortsätta skala upp de generella modellernas förmågor, men gör det på ett “ansvarsfullt” sätt med s.k. responsible scaling policies. Det är helt enkelt riktlinjer från AI-labben som innebär en villkorad paus. Man lovar att pausa om ens modeller blir för kapabla, tills man har byggt tillräckligt starka säkerhetssystem:

An RSP specifies what level of AI capabilities an AI developer is prepared to handle safely with their current protective measures, and conditions under which it would be too dangerous to continue deploying AI systems and/or scaling up AI capabilities until protective measures improve.

Alla de stora amerikanska AI-företagen har nu gått ut med frivilliga löften kring sitt säkerhetsarbete. Anthrophic var först med sin policy, och nu har även OpenAI hakat på. De delar in sina AI-modeller i olika risknivåer, där endast modeller med “medium” risk får släppas till allmänheten. Säkerhetssystemen måste alltid utvecklas minst lika snabbt som modellernas förmågor. Det är som att bygga ett allt högre staket runt en växande tiger — staketet måste alltid vara högre än vad tigern kan hoppa.

Vilken reglering måste till?

De stora AI-företagen har gjort frivilliga åtaganden kring säkerhet, men de flesta (inklusive företagen själva) anser att det inte räcker. Vi behöver nationella och internationella tillsynsmyndigheter som kan ställa krav, ungefär som vi har för kärnkraft och läkemedel. Här är de viktigaste områdena som diskuteras:

Starka myndigheter: Vi behöver bygga upp myndigheter som faktiskt förstår AI och kan övervaka utvecklingen. De måste ligga steget före AI-företagen, ha tillräcklig finansiering och kunna stötta forskning genom t.ex. nationella AI-forskningslabb.

Globalt samarbete: För att undvika en farlig kapplöpning mot superintelligens behöver vi internationella avtal och övervakning, kanske som för kärnkraft (IAEA). President Xi har faktiskt sagt att även Kina vill samarbeta kring AI-säkerhet. Ett annat förslag är att skapa ett globalt forskningscenter för AI, som CERN är för partikelfysik.

Beräkningskraft: Ett konkret uppskattning av hur kapabel, och därmed farlig, en AI-modell skulle kunna bli är att se på hur mycket beräkningskraft som krävs för att träna den. Modeller som är i nivå med antingen dagens bästa modeller (10^25 beräkningar) eller nästa version (10^26 beräkningar) bör granskas extra noga av tillsynsmyndigheter. För att få en känsla för storleken: den övre gränsen motsvarar en miljon kraftfulla hemdatorer som jobbar dygnet runt i tre månader.

Öppenhet: AI-modeller som kan påverka samhället mycket bör testas ordentligt av oberoende experter. Precis som i flygindustrin bör tillsynsmyndigheter få full insyn i utvecklingen och information om near misses. Det är också viktigt att dela information öppet så att forskare och debattörer kan följa utvecklingen.

Omvänd bevisbörda: Idag anses AI-system vara säkra tills motsatsen bevisas. Kanske borde vi vända på det? AI-företagen skulle behöva visa att deras system är säkra innan de får släppas, genom att skicka in en säkerhetsanalys som myndigheterna måste godkänna. Men istället för detaljerade regler om exakt hur allt ska göras (som i byggnormer) bör myndigheterna sätta övergripande säkerhetsmål som företagen får visa att de uppfyller, s.k. målorienterad säkerhet.

Ansvar vid skador: Vem ska betala när något går fel? Är en AI mer som en självkörande bil (där tillverkaren ansvarar) eller som en kniv (där användaren ansvarar)? Förr eller senare måste AI-företagen ta åtminstone visst ansvar för sina produkter, särskilt om de beter sig annorlunda än vad säkerhetsanalysen lovade.

Skydda samhället: Vi måste också minimera AI:s negativa effekter på samhället. Det kan handla om att AI-system måste identifiera sig som AI (s.k. “bot or not”-lagar), att förbjuda autonoma AI-system i känsliga områden som militären eller rättsväsendet, och att förhindra spridning av desinformation. Samtidigt vill vi ju att mindre företag ska kunna dra nytta av AI — kanske behövs statligt stöd för det?

We did not come to fear the future. We came here to shape it. -Barack Obama

Hur långt har vi kommit?

Det finns tre nivåer av AI-reglering som växer fram parallellt: internationella överenskommelser, regional lagstiftning (särskilt EU), och nationella initiativ.

Det viktigaste avtalet hittills är Europarådets ramkonvention från förra året. Det är juridiskt bindande men ganska vagt, och fastställer grundläggande principer om bl.a. integritet och ansvarsskyldighet. Både EU och USA har skrivit under. Det finns också flera andra internationella riktlinjer, som OECD:s rekommendationer, G7:s handlingsplan och Bletchley-deklarationen, men de är mest symboliska. Det mesta kommer dock behöva uträttas på regional eller nationell nivå. Flera länder har redan skapat nationella institut för AI-säkerhet, däribland USA, Storbritannien, och Kina.

EU har gått längst med sin nya AI-förordning (EU AI Act). Den är ambitiös och omfattande:

En ny europeisk AI-byrå ska skapas, och varje medlemsland måste ha en egen tillsynsmyndighet (låter som en mardröm att behöva ha kontakt med 27 nationella tillståndsmyndigheter för att lansera ett AI-system i Europa!)

Kraftfulla AI-system som ChatGPT klassas som systemrisk och måste rapportera diverse nyckeltal

AI-tjänster inom en lång rad områden, från sjukvård och utbildning, till modeller som bedömer kreditvärdighet eller sorterar jobbansökningar, bedöms som högrisk och måste bevisa sin säkerhet innan lansering (omvänd bevisbörda)

“Oacceptabla” tillämpningar, såsom ansiktsigenkänning i realtid i offentliga miljöer och sociala poängsystem, förbjuds helt

Både modeller med systemrisk och högriskmodeller ska genomgå oberoende modellutvärderingar innan de släpps i Europa

Förordningen gäller ju alla EU-länder. Sverige har förvisso också en AI-strategi sen 2018, ett nationellt AI-center, och en AI-kommission som nyligen överlämnade sitt förslag. Men inget av detta, vad jag kan se, fördjupar sig i frågor om säkerhet och tillsyn, utan handlar mer om hur svenska myndigheter, företag och individer ska hänga med i svängarna.

USA har valt en annan väg, med fokus på frivilliga standarder för att inte bromsa innovationen. Biden har infört vissa krav på de största AI-företagen, men det finns ingen heltäckande federal lagstiftning än: istället övervägs över 120 AI-relaterade lagförslag av kongressen, kring allt från AI-utbildning till förbud mot att AI autonomt avfyrar kärnvapen.

På lokal nivå i Kalifornien, där de flesta AI-labb har huvudkontor, försökte man nyligen införa ett förslag, SB 1047, som skulle gjort AI-företag ekonomiskt ansvariga för skador deras system orsakar. Förslaget stoppades dock av guvernören efter mycket lobbying från industrin.

Det ska bli spännande att se hur den tillträdande regeringen i USA agerar. Trump-lägret rymmer en oförutsägbar blandning av accels som Jacob Helberg, allmänna regleringsskeptiker som J.D. Vance, och uttalade doomers som Musk. Trump själv är ju som alltid ett enigma, men kan tänkas gå igång på att förhandla fram ett samarbetsavtal med Kina?

Regleringsskeptiker som J.D. Vance har förstås en poäng: omfattande regleringar för med sig risker. Kommer de att bakbinda de amerikanska AI-labben, till fördel för Kina i kapplöpningen? Kommer det att premiera etablerade aktörerna framför små bolag som inte har tillräckliga resurser? För de stora språkmodellerna (GPT-4 etc) är nog problemet mindre: några säkerhetsanalyser mer eller mindre kommer inte att vara avskräckande för ett organisation som lägger en miljard på att träna en modell, och eftersom inträdesbarriärerna är så enorma finns det ändå inte så många små konkurrenter.

Däremot verkar EU:s AI-förordning kunna bli en mardröm för ett mindre europeiskt bolag som vill lansera olika tjänster inom t ex utbildning:

Once a system has been categorized as ‘high risk’, it faces extreme restrictions. Imagine you have a start-up and have built an AI teacher — an obvious and good AI use case. Before you may release it in the EU you must do the following:

Build a comprehensive ‘risk management system’

Ensure the system is trained on data that has ‘the appropriate statistical properties’

Draw up extensive technical documentation

Create an ‘automatic recording of events across the systems lifetime’

Build a system so a deployer can ‘interpret a system’s output’

Build in functions for ‘human oversight’ and a ‘stop button’

Build a cybersecurity system

Build a ‘quality management system’ that includes ‘the setting-up, implementation and maintenance of a post-market monitoring system’

Keep all the above for the next 10 years

Appoint an ‘authorized representative which is established in the Union’

Undergo a ‘conformity assessment’ verifying that you have done the above with a designated authority and receive a certificate

Undergo a fundamental rights impact assessment and submit that to the Market Surveillance Authority

Draw up an EU Declaration of Conformity

Register in an EU database

If you get any of that wrong, you may be fined up to the higher of 15 million euros or 3% of total revenue.

Samhällsomställningar

När vi pratar om AI handlar det inte bara om regler och lagar. Samhället måste också förbereda sig på stora förändringar. McKinsey uppskattar att AI kan automatisera upp till 800 miljoner jobb globalt till 2030. När ångmaskinen och elektriciteten kom förändrades samhället dramatiskt — men då hade vi årtionden på oss att anpassa oss. Nu kan samma omställning ske på bara några år.

Historien visar att snabba samhällsförändringar kan skapa oro och konflikter. Ta till exempel vad som hände i amerikanska rostbältet när fabrikerna automatiserades: arbetslöshet, drogproblem och en känsla av hopplöshet som lever kvar än idag. Fast den här gången kan förändringen bli mycket mer omfattande.

Så vad gör vi? Till att börja med får vi hoppas att Ricardo hade rätt (som vi diskuterade i #73) och nya jobb skapas i samma takt. Måste vi kanske, som Noah Smith föreslår, begränsa datacenters tillgång till energi för att säkerställa att det fortfarande finns en alternativkostnad, och ett människor kan ha en komparativ fördel på något område? Kommer folk att ha en artspecifik preferens för att köpa vissa tjänster av människor?

Annars får vi helt enkelt hoppas på att folk kan få ett bra, eller snarare bättre, liv utan att lönearbeta. Antrophics Amodei är övertygad om att det är möjligt:

On the question of meaning, I think it is very likely a mistake to believe that tasks you undertake are meaningless simply because an AI could do them better. Most people are not the best in the world at anything, and it doesn’t seem to bother them particularly much. [...] I spend plenty of time playing video games, swimming, walking around outside, and talking to friends, all of which generates zero economic value. [...] In any case I think meaning comes mostly from human relationships and connection, not from economic labor. People do want a sense of accomplishment, even a sense of competition, and in a post-AI world it will be perfectly possible to spend years attempting some very difficult task with a complex strategy, similar to what people do today when they embark on research projects, try to become Hollywood actors, or found companies.

Men även om människor upplever mening också i en värld där ingen jobbar blir det lite oklart hur världens ekonomiska resurser ska fördelas. Många förespråkar ju medborgarlön, där alla får samma lön. Men det riskerar att bli väldigt statiskt: det kommer sannolikt att skapas en ärftlig överklass (de som ägde aktier i Open AI 2025…?), och även om den stora massan kan få ett bekvämt liv så finns det ju ingen social rörlighet och inget att kämpa för. Marc Andreessen är definitivt inte särskilt övertygad:

We believe a Universal Basic Income would turn people into zoo animals to be farmed by the state. Man was not meant to be farmed; man was meant to be useful, to be productive, to be proud.

Kanske kan man komma fram till något slags syntetiskt system, där människor motiveras att göra vissa saker framför andra, antingen för att det är mer värdefullt för samhället eller för att det helt enkelt bedöms vara mer värdigt för individerna?

Och arbetsmarknaden är bara början. Här är några andra utmaningar vi behöver ta tag i:

Utbildning: Vad ska skolan lära ut när AI kan alla fakta?

Demokrati: Hur skyddar vi oss mot AI-genererad propaganda som kan skräddarsys för varje väljare?

Rättvisa: Hur ser vi till att AI-system behandlar alla rättvist och inte diskriminerar?

Rättigheter: Hur kan vi som medborgare få rätt mot ett kraftfullt AI-system som behandlar oss orättvist?

Tillit: Hur vet vi vem vi egentligen pratar med på telefon när AI kan härma röster perfekt?

Säkerhet: Ska vi tillåta autonoma vapen som själva väljer sina mål?

Jämlikhet: Hur hindrar vi att AI ökar klyftorna mellan rika och fattiga, både inom och mellan länder?

Det här är frågor som borde dominera samhällsdebatten de närmaste åren. För även om AI kan göra världen mycket bättre, måste vi se till att fördelarna kommer alla till del.

Vad tycker jag?

Jag anser att vi måste vara väldigt försiktiga när vi börjar närma oss superintelligens. Det är omöjligt att förutsäga exakt vad som händer när vi får en konkurrerande digital art på planeten. Det kommer inte bara innebära ett samhällsskifte som när vi gick från att vara jägare/samlare till att vara bofasta, fast tusen gånger snabbare. Det är snarare som om vi var homo erectus och homo sapiens plötsligt skulle dyka upp en eftermiddag — fast den här gången en art som är miljontals gånger smartare än oss.

Men det finns hopp: superintelligens är inte något som “bara händer”. Det kommer bara ske om stora stater aktivt tillåter de massiva investeringar som krävs. Det betyder att utvecklingen av superintelligens, till skillnad från många andra teknologier som kärnvapen eller bioteknik, faktiskt går att kontrollera om världens ledare bestämmer sig för det.

Idag, när vi fortfarande har en bra bit kvar, tror jag på en balanserad mellanväg med smart reglering av de ledande AI-labben. Vi bör fortsätta utveckla AI: dels för de enorma möjligheter det ger, dels för att inte hamna efter våra geopolitiska konkurrenter. Genom att fortsätta utvecklingen under statlig översyn kan vi förhoppningsvis förstå och hantera riskerna. När vi närmar oss superintelligens, eller när riskerna blir för stora, pausar vi i linje med responsible scaling policies.

Men är vi inte då tillbaka på ruta ett, med risken att Kina inte pausar utan går om? Nej, det finns en avgörande skillnad: när det gäller superintelligens har alla stater, inte minst auktoritära regimer, mycket att förlora på att släppa kontrollen. Det borde göra det möjligt att komma överens om begränsningar internationellt, ungefär som vi lyckades med kärnvapen under kalla kriget.

Däremot är det viktigt att mer branschspecifika AI-tillämpningar, som inte är på väg mot någon allmän superintelligens, inte kvävs av omfattande byråkrati. Jag är skeptisk mot den långa listan på högrisk-områden i EU-förordningen som riskerar att döda mycket innovation. Även om det är rimligt att OpenAI har bevisbördan för att GPT-7 är säker betyder det inte att regelverket behöver drastiskt skärpas för AI som hjälper lärare rätta prov.

Avslutningsvis

Det kommer inte vara enkelt att navigera den här utmaningen. Vi ska se till att demokratierna vinner kapplöpningen om superintelligens, samtidigt som vi bygger system som kan styras av människan och inte missbrukas av bovar. Och parallellt måste vi hantera de snabba samhällsförändringarna och se till att ingen hamnar mellan stolarna. Men som John F. Kennedy sa i sitt berömda måntal:

We choose to go to the moon in this decade and do the other things, not because they are easy, but because they are hard, because that goal will serve to organize and measure the best of our energies and skills, because that challenge is one that we are willing to accept, one we are unwilling to postpone, and one which we intend to win, and the others, too.

Att hantera superintelligens på rätt sätt är dessutom oändligt mycket viktigare än att komma först till månen. Det handlar inte bara om en möjlighet, utan också om en skyldighet vår generation har. Som Gandalf sa till Frodo:

“I wish it need not have happened in my time,” said Frodo.

“So do I,” said Gandalf, “and so do all who live to see such times. But that is not for them to decide. All we have to decide is what to do with the time that is given us.”

De kommande åren har vi en unik möjlighet att forma framtiden. Låt oss ta den på allvar.

Det här var allt för idag, och nog allt om AI på ett litet tag.

Om du har vänner som du tror skulle gilla nyhetsbrevet, vidarebefordra det till dem eller tipsa dem om att prenumerera för att få framtida utskick (det är helt gratis!).

—Jacob